Vista

expandida de una computadora personal.

Una computadora o computador (del

inglés computer y este del latíncomputare -calcular), también

denominada ordenador (del francés ordinateur,

y este del latín ordinator), es una máquina electrónica que recibe y procesa datospara

convertirlos en información útil. Una computadora es una colección decircuitos integrados y otros componentes

relacionados que puede ejecutar con exactitud, rapidez y de acuerdo a lo

indicado por un usuario o automáticamente por otro programa, una gran variedad

de secuencias o rutinas de instruccionesque

son ordenadas, organizadas y sistematizadas en

función a una amplia gama de aplicaciones prácticas y precisamente

determinadas, proceso al cual se le ha denominado con el nombre de programación y al

que lo realiza se le llama programador. La

computadora, además de la rutina o programa informático, necesita de datos específicos

(a estos datos, en conjunto, se les conoce como "Input" en inglés

o de entrada) que deben ser suministrados, y que son requeridos al

momento de la ejecución, para proporcionar el producto final del procesamiento

de datos, que recibe el nombre de "output" o de salida.

La información puede ser entonces utilizada, reinterpretada, copiada,

transferida, o retransmitida a otra(s) persona(s), computadora(s) o

componente(s) electrónico(s) local o remotamente usando diferentes sistemas

de telecomunicación, que puede ser grabada, salvada

o almacenada en algún tipo de dispositivo o unidad de almacenamiento.

La

característica principal que la distingue de otros dispositivos similares, como

la calculadora no programable, es que es una máquina

de propósito general, es decir, puede realizar tareas muy diversas, de acuerdo

a las posibilidades que brinde los lenguajes de programación y el hardware.

La Computadora

Arquitectura

Artículo

principal: Arquitectura de computadoras.

A pesar de

que las tecnologías empleadas en las computadoras digitales han cambiado mucho

desde que aparecieron los primeros modelos en los años

40, la mayoría todavía utiliza laArquitectura de von Neumann,

publicada a principios de los años

1940 por John

von Neumann, que otros autores atribuyen a John Presper Eckert y John William Mauchly.

La

arquitectura de Von Neumann describe una computadora con 4 secciones

principales: la unidad aritmético lógica (ALU por sus siglas del

inglés: Arithmetic Logic Unit), la unidad

de control, lamemoria central, y los dispositivos

de entrada y salida (E/S). Estas partes están interconectadas por

canales de conductores denominados buses:

· La memoria es una secuencia de celdas de

almacenamiento numeradas, donde cada una es un bit o

unidad de información. La instrucción es la información necesaria para realizar

lo que se desea con el computador. Las «celdas» contienen datos que se

necesitan para llevar a cabo las instrucciones, con el computador. El número de

celdas varían mucho de computador a computador, y las tecnologías empleadas

para la memoria han cambiado bastante; van desde los relés electromecánicos,

tubos llenos de mercurio en los que se formaban los pulsos acústicos, matrices

de imanes permanentes, transistores individuales a circuitos integrados con

millones de celdas en un solo chip. En general, la memoria puede ser reescrita

varios millones de veces (memoria

RAM); se parece más a una pizarra que a una lápida (memoria ROM) que sólo

puede ser escrita una vez.

· El procesador (también

llamado Unidad central de procesamiento o CPU) consta

de manera básica de los siguientes elementos:

Un típico

símbolo esquemático para una ALU: A y B son operandos; R es la salida; F es la

entrada de la unidad

de control; D es un estado de la salida.

· La unidad aritmético lógica o

ALU es el dispositivo diseñado y construido para llevar a cabo

las operaciones elementales como las operaciones aritméticas (suma,

resta, ...), operaciones lógicas (Y,

O, NO), y operaciones de comparación o relacionales. En esta unidad es en donde se hace todo el

trabajo computacional.

· La unidad

de control sigue la dirección de las posiciones en memoria que

contienen la instrucción que el computador va a realizar en ese momento;

recupera la información poniéndola en la ALU para la operación que debe

desarrollar. Transfiere luego el resultado a ubicaciones apropiadas en la

memoria. Una vez que ocurre lo anterior, la unidad de control va a la siguiente

instrucción (normalmente situada en la siguiente posición, a menos que la

instrucción sea una instrucción de salto, informando al ordenador de que la

próxima instrucción estará ubicada en otra posición de la memoria).

Los

procesadores pueden constar de además de las anteriormente citadas, de otras

unidades adicionales como la unidad de Coma Flotante

· Los dispositivos

de Entrada/Salida sirven a la computadora para obtener información del mundo exterior

y/o comunicar los resultados generados por el computador al exterior. Hay una

gama muy extensa de dispositivos E/S como teclados, monitores, unidades de disco

flexible o cámaras

web.

Computadora

de Escritorio.

Periféricos y dispositivos auxiliares

Artículo

principal: Periférico.

Monitor

Artículo

principal: Monitor de computadora.

El monitor o pantalla

de computadora, es un dispositivo de salida que, mediante una interfaz,

muestra los resultados, o los gráficos del procesamiento de una computadora.

Existen varios tipos de monitores: los de tubo de rayos catódicos (o CRT), los

de pantalla de plasma (PDP), los de pantalla de cristal líquido (o LCD),

de paneles de diodos orgánicos de emisión

de luz (OLED), o Láser-TV, entre

otros.

Teclado

Artículo

principal: Teclado de computadora.

Un teclado

de computadora es un periférico, físico o virtual (por ejemplo teclados en

pantalla o teclados táctiles), utilizado para la introducción de órdenes y

datos en una computadora. Tiene su origen en los teletipos y

lasmáquinas de escribir eléctricas, que se

utilizaron como los teclados de los primeros ordenadores y dispositivos de

almacenamiento (grabadoras de cinta de papel y tarjetas perforadas). Aunque

físicamente hay una miríada de formas, se suelen clasificar principalmente por

la distribución de teclado de su zona alfanumérica,

pues salvo casos muy especiales es común a todos los dispositivos y fabricantes

(incluso para teclados árabes y japoneses).

Ratón

Artículo

principal: Ratón.

El mouse (del inglés,

pronunciado [ˈmaʊs]) o ratón es un periférico de

computadora de uso manual, utilizado como entrada o control de datos. Se

utiliza con una de las dos manos del

usuario y detecta su movimiento relativo en dos

dimensiones por la superficie horizontal en la que se apoya,

reflejándose habitualmente a través de un puntero o flecha en el monitor. Anteriormente, la información del desplazamiento era transmitida

gracias al movimiento de una bola debajo del ratón, la cual accionaba dos

rodillos que correspondían a los ejes X e Y. Hoy, el puntero reacciona a los

movimientos debido a un rayo de luz que se refleja entre el ratón y la

superficie en la que se encuentra. Cabe aclarar que un ratón óptico apoyado en

un espejo o sobre un barnizado por ejemplo es inutilizable, ya que la luz láser

no desempeña su función correcta. La superficie a apoyar el ratón debe ser

opaca, una superficie que no genere un reflejo, es recomendable el uso de alfombrillas.

Impresora

Artículo

principal: Impresora.

Una impresora es

un periférico de computadora que permite producir una

copia permanente de textos o gráficos de documentos almacenados en formato

electrónico, imprimiendo en papel de lustre los datos en medios físicos,

normalmente en papel o transparencias, utilizando cartuchos de tinta o

tecnología láser. Muchas impresoras son usadas como periféricos, y están

permanentemente unidas a la computadora por un cable. Otras impresoras,

llamadas impresoras de red, tienen una interfaz de red interna (típicamente

wireless o Ethernet), y que puede servir como un dispositivo para imprimir en

papel algún documento para cualquier usuario de la red. Hoy en día se

comercializan impresoras multifuncionales que aparte de sus funciones de

impresora funcionan simultáneamente como fotocopiadora y escáner, siendo éste

tipo de impresoras las más recurrentes en el mercado.

Escáner

Artículo

principal: Escáner de computadora.

En informática, un escáner (del idioma

inglés: scanner) es un periférico que

se utiliza para convertir, mediante el uso de la luz, imágenes o cualquier otro

impreso a formato digital. Actualmente vienen unificadas con las impresoras

formandomultifunciones

Impresora

multifunción

Impresora

multifuncional.

Artículo

principal: Impresora multifunción.

Una impresora

multifunción o dispositivo multifuncional es un periférico que se

conecta a la computadora y que posee las siguientes funciones dentro de un

único bloque físico: Impresora, escáner, fotocopiadora, ampliando o reduciendo el original, fax (opcionalmente).

Lector de memoria para la impresión directa de fotografías de cámaras

digitales Disco duro (las unidades más grandes utilizadas en

oficinas) para almacenar documentos e imágenes En ocasiones, aunque el fax no

esté incorporado, la impresora multifunción es capaz de controlarlo si se le

conecta a un puerto USB.

Almacenamiento

Secundario

Artículo

principal: Disco duro.

Artículo

principal: Unidad de Estado Sólido.

El disco

duro es un sistema de grabación magnética digital, es donde

en la mayoría de los casos reside el Sistema

operativode la computadora. En los discos duros se almacenan los datos del

usuario. En él encontramos dentro de la carcasa una serie de platos metálicos

apilados girando a gran velocidad. Sobre estos platos se sitúan los cabezales encargados

de leer o escribir los impulsos magnéticos.

Una unidad de estado sólido es un sistema de memoria no

volátil. Están formados por varios chips de memoria NAND Flash en

su interior unidos a una controladora que gestiona todos los datos que se

transfieren. Tienen una gran tendencia a suceder definitivamente a los discos

duros mecánicos por su gran velocidad y tenacidad. Al no estar formadas por

discos en ninguna de sus maneras, no se pueden categorizar como tal, aunque

erróneamente se tienda a ello.

Altavoces

Los altavoces se

utilizan para escuchar los sonidos emitidos por el computador, tales como

música, sonidos de errores, conferencias, etc.

· Altavoces de las placas base: Las

placas base suelen llevar un dispositivo que emite pitidos para indicar

posibles errores o procesos, o para indicar acciones para las personas con

discapacidades visuales, como la activación del bloq num, bloq mayus.

Otros

conceptos y curiosidades

En la

actualidad se puede tener la impresión de que los computadores están ejecutando

varios programas al mismo tiempo. Esto se conoce como multitarea, y es más

común que se utilice el segundo término. En realidad, la CPU ejecuta

instrucciones de un programa y después tras un breve periodo de tiempo, cambian

a un segundo programa y ejecuta algunas de sus instrucciones. Esto crea la

ilusión de que se están ejecutando varios programas simultáneamente,

repartiendo el tiempo de la CPU entre los programas. Esto es similar a la

película que está formada por una sucesión rápida de fotogramas. El sistema

operativo es el programa que generalmente controla el reparto del tiempo. El

procesamiento simultáneo viene con computadoras de más de un CPU, lo que da

origen al multiprocesamiento.

El sistema

operativo es una especie de caja de herramientas lleno de utilerías

que sirve para decidir, por ejemplo, qué programas se ejecutan, y cuándo, y qué

fuentes (memoria o dispositivos E/S) se utilizan. El sistema operativo tiene

otras funciones que ofrecer a otros programas, como los códigos que sirven a

los programadores, escribir programas para una máquina sin necesidad de conocer

los detalles internos de todos los dispositivos electrónicos conectados.

En la

actualidad se están empezando a incluir en las distribuciones donde se incluye

el sistema operativo, algunos programas muy usados, debido a que es ésta una

manera económica de distribuirlos. No es extraño que un sistema operativo

incluya navegadores deInternet, procesadores de texto, programas de correo electrónico, interfaces de red,

reproductores de películas y otros programas que antes se tenían que conseguir

e instalar separadamente.

Los

primeros computadores digitales, de gran tamaño y coste, se utilizaban

principalmente para hacer cálculos científicos. ENIAC, uno de

los primeros computadores, calculaba densidades de neutrón transversales para

ver si explotaría la bomba de hidrógeno. El CSIR Mk I, el

primer ordenador australiano, evaluó patrones de precipitaciones para un gran

proyecto de generación hidroeléctrica. Los primeros visionarios vaticinaron que

la programación permitiría jugar al ajedrez, ver películas y otros usos.

La gente

que trabajaba para los gobiernos y las grandes empresas también usó los

computadores para automatizar muchas de las tareas de recolección y

procesamiento de datos, que antes eran hechas por humanos; por ejemplo,

mantener y actualizar la contabilidad y los inventarios. En el mundo académico,

los científicos de todos los campos empezaron a utilizar los computadores para

hacer sus propios análisis. El descenso continuo de los precios de los

computadores permitió su uso por empresas cada vez más pequeñas. Las empresas,

las organizaciones y los gobiernos empezaron a emplear un gran número de

pequeños computadores para realizar tareas que antes eran hechas por

computadores centrales grandes y costosos. La reunión de varios pequeños

computadores en un solo lugar se llamaba torre de servidores[cita requerida].

Con la

invención del microprocesador en 1970, fue

posible fabricar computadores muy baratos. Nacen los computadores personales (PC), los que se hicieron famosos para llevar a cabo diferentes

tareas como guardar libros, escribir e imprimir documentos, calcular

probabilidades y otras tareas matemáticas repetitivas con hojas

de cálculo, comunicarse mediante correo electrónico e Internet. Sin

embargo, la gran disponibilidad de computadores y su fácil adaptación a las

necesidades de cada persona, han hecho que se utilicen para varios propósitos.

Al mismo

tiempo, los pequeños computadores son casi siempre con una programación fija,

empezaron a hacerse camino entre las aplicaciones del hogar, los coches, los

aviones y la maquinaria industrial. Estos procesadores integrados controlaban

el comportamiento de los aparatos más fácilmente, permitiendo el desarrollo de

funciones de control más complejas como los sistemas de freno antibloqueo en

los coches. A principios del siglo 21, la mayoría de los aparatos eléctricos,

casi todos los tipos de transporte eléctrico y la mayoría de las líneas de

producción de las fábricas funcionan con un computador. La mayoría de los

ingenieros piensa que esta tendencia va a continuar.

Actualmente,

los computadores personales son usados tanto para la investigación como para el

entretenimiento (videojuegos), pero los grandes computadores aún sirven

para cálculos matemáticos complejos y para otros usos de la ciencia,

tecnología, astronomía, medicina, etc.

Tal vez el

más interesante "descendiente" del cruce entre el concepto de la PC o

computadora personal y los llamadossupercomputadores sea la Workstation o

estación de trabajo. Este término, originalmente utilizado para equipos y

máquinas de registro, grabación y tratamiento digital de sonido, y ahora

utilizado precisamente en referencia a estaciones de trabajo (traducido

literalmente del inglés), se usa para dar nombre a equipos que, debido sobre

todo a su utilidad dedicada especialmente a labores de cálculo científico,

eficiencia contra reloj y accesibilidad del usuario bajo programas y software

profesional y especial, permiten desempeñar trabajos de gran cantidad de

cálculos y "fuerza" operativa. Una Workstation es, en esencia, un

equipo orientado a trabajos personales, con capacidad elevada de cálculo y

rendimiento superior a los equipos PC convencionales, que aún tienen

componentes de elevado coste, debido a su diseño orientado en cuanto a la

elección y conjunción sinérgica de sus componentes. En estos casos, el software

es el fundamento del diseño del equipo, el que reclama, junto con las

exigencias del usuario, el diseño final de la Workstation.

Etimología de la palabra ordenador

PC con

interfaz táctil.

La palabra

española ordenador proviene del término francés ordinateur,

en referencia a Dios que pone orden en el mundo ("Dieu qui met de l'ordre

dans le monde").En

parte por cuestiones de marketing, puesto que la descripción realizada

por IBM para

su introducción en Francia en 1954 situaba las capacidades de actuación de la

máquina cerca de la omnipotencia, idea equivocada que perdura hoy en día al

considerar que la máquina universal de Turing es capaz de computar

absolutamente todo. En

1984, académicos franceses reconocieron, en el debate "Les jeunes,

la technique et nous", que el uso de este sustantivo es incorrecto,

porque la función de un computador es procesar datos, no dar órdenes.Mientras

que otros, como el catedrático de filología latina Jacques Perret, conocedores

del origen religioso del término, lo consideran más correcto que las

alternativas.1

El uso de

la palabra ordinateur se ha exportado a algunos idiomas de

la península Ibérica, como el aragonés, el asturiano, el gallego, el castellano, el catalán y

el euskera. El

español que se habla en Iberoamérica así

como los demás idiomas europeos, como el portugués, el alemán y el holandés,

utilizan derivados del término computare.Computadora portátilUna computadora portátil (conocida también como ordenador portátil en España, y como laptop en algunos países influenciados por el habla inglesa) es un ordenador personal móvil o transportable, que pesa normalmente entre 1 y 3 kg. Los ordenadores portátiles son capaces de realizar la mayor parte de las tareas que realizan los ordenadores de escritorio, con similar capacidad y con la ventaja de su peso y tamaño reducidos; sumado también a que tienen la capacidad de operar por un período determinado sin estar conectadas a una red eléctrica.Computadora portátil de escritorioUna computadora portátil de escritorio o desknote es un híbrido entre una computadora de escritorio y una computadora portátil tradicional.ECS introdujo la computadora portátil de sobremesa al mundo de las computadoras a finales de 2001. Una computadora portátil de sobremesa es una computadora portátil con la tecnología y especificaciones (incluyendo potencia y velocidad) más recientes de computadoras de escritorio; combina la unidad principal de computadora (p.e. placa madre, CPU, disco duro, puertos externos, etc.) con una pantalla de cristal líquido (LCD); por tanto, una computadora portátil de escritorio generalmente tiene un tamaño similar a un portátil grande, aunque a diferencia de éstos, los desknotes requieren un teclado y un ratón externo. HistoriaLa primera computadora portátil considerada como tal fue la Epson HX-20, desarrollada en 1981, a partir de la cual se observaron los grandes beneficios para el trabajo de científicos, militares, empresarios y otros profesionales que vieron la ventaja de poder llevar con ellos su computadora con toda la información que necesitaban de un lugar a otro.La Osborne 1 salió al mercado comercial en abril de 1981, con el formato que actualmente los distingue, aunque entonces eran sumamente limitadas, incluso para la tecnología de la época. En 1995, con la llegada de Windows 95, la venta de las portátiles se incrementó notablemente, y en la actualidad rebasa la ventas de los equipos de escritorio. En el tercer trimestre de 2008, las ventas de las portátiles superaron por primera vez las de los equipos de escritorio, según la firma de investigación iSuppli Corp. Breve historia de los ordenadores portátiles Probablemente

una de las revoluciones más significativas dentro del mundo de los

ordenadores, exceptuando la popularización de Internet, fue la aparición

de los ordenadores portátiles, un equipo informático de prestaciones

similares a los de sobremesa aunque con la ventaja de poder ser

trasladados a cualquier lugar. Probablemente

una de las revoluciones más significativas dentro del mundo de los

ordenadores, exceptuando la popularización de Internet, fue la aparición

de los ordenadores portátiles, un equipo informático de prestaciones

similares a los de sobremesa aunque con la ventaja de poder ser

trasladados a cualquier lugar.Con unos componentes reducidos a su mínima expresión tanto en lo que respecta a tamaño como en peso, en los últimos años el ordenador portátil se ha transformado en una herramienta imprescindible para muchas personas. Asimismo, la utilización de baterías como fuente de alimentación permite que profesionales puedan aprovechar los tiempos muertos en sus desplazamientos para continuar trabajando o bien trasladar su oficina portátil hacia lugares no habituales como por ejemplo al pie de una obra. Dicho concepto de ordenador no es ni mucho menos nuevo, pues ya a finales de la década de los sesenta el ingeniero Alan Kay de la compañía Xerox sentó las bases del ordenador portátil con su Dynabook (en la imagen), un ordenador portátil en su mínima expresión y enfocado hacia niños y niñas. A destacar que el Dynabook fue la máquina con la cual Microsoft se basó a la hora de crear su Tablet PC. Ya en el año 1975 la gigante IBM presentó su modelo 5100, un equipo informático que incluía una pequeña pantalla de cinco pulgadas que asombró al mundo por las pequeñas dimensiones del conjunto. Probablemente uno de sus mejores argumentos fue que solo ocupaba el espacio de una pequeña maleta, aunque el conjunto tenia un peso de veinticinco kilogramos, algo que lo hacia evidentemente incomodo de trasladar. En cuanto a su precio este también era considerable, pues oscilaba entre los once y veinte mil dólares. En 1981 la compañía Osborne, dedicada hasta entonces a la publicación de libros técnicos sobre informática, presentó una interesante propuesta llamada Osborne 1, la cual consistía en un ordenador con sistema operativo CP/M y microprocesador Z80 con teclado, puertos de comunicación y una pequeña pantalla incorporada, siendo el peso de "solamente" once kilogramos. Dicha máquina se vendió muy bien en los Estados Unidos aunque desafortunadamente su versión mejorada no tuvo tanto éxito, básicamente debido a la aparición de los primeros IBM PC. Ello obligó a la compañía Osborne realizar suspensión de pagos en el año 1983. A su vez la japonesa Epson comercializó en el año 1983 su HX-20, una máquina realmente interesante orientada a profesionales y todavía con un aspecto bastante diferente a lo que hoy por hoy entendemos como ordenador portátil. De hecho este computador se asemejaba bastante a un microordenador de la época (léase Spectrum o Amstrad) al cual se le había integrado una pantalla en la carcasa además de una diminuta impresora. A destacar que la citada pantalla era de LCD y solamente permitía la aparición de texto en cuatro líneas de veinte caracteres. No obstante, el peso total del conjunto ya era de poco más de un kilo y medio, contando con un precio de aproximadamente ochocientos dólares. No obstante, el primer ordenador con el monitor haciendo las funciones de tapa, aproximadamente tal y como entendemos actualmente un ordenador portátil, fue comercializado entre los años 1981 y 1986 por la compañía australiana Dulmison. El ordenador se denominó Dulmont Mágnum y contaba con una pantalla de LCD de 25x80 caracteres. Dicha máquina era interesante debido a que utilizaba el procesador Intel 80186 que le otorgaba una potencia más que aceptable. Por su parte, las pantallas del tipo VGA a todo color no se popularización hasta inicios de la década de los noventa aunque ya en 1988 el portátil Compaq SLT/286 ya disponía de este avance. Para finalizar este articulo, indicar que en el año 2005 miembros del Instituto Tecnológico de Massachussets liderados por Nicholas Negroponte y Lewis Stiward introdujeron el concepto de OLPC (siglas en ingles de "Un ordenador por niño"). Dicho proyecto conocido popularmente por "El ordenador de los cien dólares" todavía hoy está en desarrollo y consiste en la fabricación de ordenadores a muy bajo precio. Estos serán vendidos a gobiernos para que a su vez sean entregados a niños y niñas de sus escuelas. A destacar que este proyecto tan ambicioso como sugerente pretende que cada niño del mundo pueda tener su propio ordenador con el cual aprender y aprovecharse de todos los recursos que existen en Internet. El sistema operativo de la máquina es Linux con licencia GNU y solamente puede realizar tareas básicas como escribir documentos, acceder a Internet, realizar dibujos y poca cosa más, aunque gracias a su buena acogida también existe la posibilidad de instalar el sistema operativo Windows XP. Aunque dicho ordenador nació como proyecto educativo, este portátil se empezó a comercializar en Estados Unidos a partir del año 2007 a un precio de doscientos dólares, la mitad de los cuales sirven para que un niño del tercer mundo reciba un ordenador portátil idéntico. Desafortunadamente el proyecto ha recibido serias críticas ya sea de fabricantes de hardware, de software o incluso de consumidores en general, estos últimos defraudados por el hecho que sus promotores abandonaran pronto el proyecto para fundar sus propias compañías comerciales aprovechando el "tirón" de la iniciativa. La computadora portátil de 100 dólaresImpacto social"Lo crucial es que el crecer en una sociedad moderna ha sufrido tres cambios fundamentales: la modificación de las relaciones familiares, la restructuración de las fases de la niñez y de la juventud, y un crecimiento de los aparatos tecnológicos día a día". La comunicación es fundamental especialmente para los jóvenes que viven en esta época de modernización.Los aparatos tecnológicos como las computadoras portátiles, han hecho esta comunicación de persona a persona inferior ya que a través de esta tecnología uno se puede comunicar sin necesidad de estar de frente a la otra persona. El poder comunicarse a través de estos medios le han facilitado a muchos sus trabajos ya que tienen "mayor libertad y comodidad", por esto es una gran ventaja. Pero también existe una desventaja de estos avances en la tecnología como la computadora portátil, nos han hecho ser personas más individualistas, o sea apartes de la sociedad, y en una sociedad tan competitiva como esta las personas deben desarrollarse tanto en el ámbito social como en el tecnológico, y crear un balance entre ambos para poder progresar. El impacto social de la tecnología y la ciencia han sido soporte de la elevación del bienestar de una población y su calidad de vida, sin descuidar los aspectos materiales relacionados con ellos, tales como la alimentación, la vivienda, el transporte, las comunicaciones y toda la actividad de infraestructura económica que resulta imprescindible para el desarrollo un país y sus personas. ComponentesMuchos de los componentes de un ordenador portátil son similares a los componentes de los ordenadores de escritorio, pero habitualmente son de menor tamaño, con componentes similares, algunos de los cuales se citan a continuación:

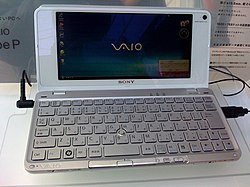

Características

SubportátilSon una nueva clase de portátiles que eliminan la unidad óptica, y reducen la potencia de otros componentes como la tarjeta gráfica, con el fin de disminuir el tamaño físico de las máquinas (y en ocasiones el coste), capaces de entrar en el bolsillo de un pantalón, como en el caso de los VAIO serie P.Su capacidad de procesamiento es notablemente menor que los portátiles normales, por eso necesitan sistemas operativos diseñados específicamente, además del uso de almacenamiento remoto. Fabricantes y marcasMuchas marcas, incluidas las más importantes, no diseñan y no fabrican sus ordenadores portátiles. En su lugar, un pequeño número de fabricantes de diseños originales (ODM) diseñan los nuevos modelos de ordenadores portátiles, y las marcas eligen los modelos que se incluirán en su alineación. En 2006, siete ODM principales fabricaron 7 de cada 10 ordenadores portátiles en el mundo, con el más grande (Quanta Computer) que tiene 30% de cuota de mercado mundial. Por lo tanto, a menudo son modelos idénticos a disposición tanto de una multinacional y de una empresa de bajo perfil ODM de marca local. La gran mayoría de ordenadores portátiles en el mercado son fabricados por un puñado de fabricantes de diseños originales (ODM).Los más importantes son:

VentajasEn la actualidad, una computadora de escritorio puede soportar cualquier tipo de UCP, memoria, gráfico; por lo tanto, una computadora portátil de escritorio debería poder ofrecer el mismo tipo de soporte que el correspondiente a una computadora de escritorio. Una computadora de escritorio presenta algunas ventajas:

Lista de marcas comerciales de portátiles

Video de la evolución de los portatiles

El primer ordenador portátil de la historiaEn abril de 1982 se puso a la venta el que es considerado comúnmente como el primer ordenador portátil de la historia, el GRiD Compass 1101. Creado 3 años atrás por el diseñador industrial británico Bill Moggridge, este modelo contaba con un procesador Intel 8086, una pantalla electroluminiscente de 320x200 píxeles, 256 KB de memoria DRAM, corría el sistema operativo Grid-OS, disponía de un módem arcaico y pesaba 5 Kg.No era desde luego un producto para el ciudadano de a pie, ya que las excelentes características técnicas que tenía para la época de la que estamos hablando hicieron de él un ordenador extremadamente caro: su precio era de 8.150 dólares. Aunque fue concebido y fabricado para atraer la atención de los altos ejecutivos, fueron finalmente el ejército estadounidense y la NASA quienes mayor partido le sacaron. Sin ir más lejos, la agencia espacial lo utilizó en diversas misiones de sus lanzaderas durante los años '80 y '90 debido a su contenido tamaño y peso. En la imagen que tenéis bajo estas líneas se puede ver al astronauta John Creighton posando junto al GRid Compass 1101 en una misión del transbordador espacial Discovery en 1985: Curioso vídeo de la evolución de los sistemas operativos. La primera generacion de ordenadores Primera generación de computadorasLa primera generación de computadoras abarca desde el año 1938 hasta el año 1958, época en que la tecnología electrónica era a base de bulbos o tubos de vacío, y la comunicación era en términos de nivel más bajo que puede existir, que se conoce como lenguaje de máquina.Características:

La primera generación de computadoras y sus antecesores, se describen en la siguiente lista de los principales modelos de que constó:

El tubo de vacíoLa era de la computación moderna empezó con una ráfaga de desarrollo antes y durante la Segunda Guerra Mundial, como circuitos electrónicos, relés, condensadores y tubos de vacío que reemplazaron los equivalentes mecánicos y los cálculos digitales reemplazaron los cálculos analógicos.Las computadoras que se diseñaron y construyeron entonces se denominan a veces "primera generación" de computadoras. La primera generación de computadoras eran usualmente construidas a mano usando circuitos que contenían relés y tubos de vacío, y a menudo usaron tarjetas perforadas (punched cards) o cinta de papel perforado (punched paper tape) para la entrada de datos [input] y como medio de almacenamiento principal (no volátil). El almacenamiento temporal fue proporcionado por las líneas de retraso acústicas (que usa la propagación de tiempo de sonido en un medio tal como alambre para almacenar datos) o por los tubos de William (que usan la habilidad de un tubo de televisión para guardar y recuperar datos). A lo largo de 1943, la memoria de núcleo magnético estaba desplazando rápidamente a la mayoría de las otras formas de almacenamiento temporal, y dominó en este campo a mediados de los 70. En 1936 Konrad Zuse empezó la construcción de la primera serie Z, calculadoras que ofrecen memoria (inicialmente limitada) y programabilidad. Las Zuses puramente mecánicas, pero ya binarias, la Z1 terminada en 1938 nunca funcionó fiablemente debido a los problemas con la precisión de partes. En 1937, Claude Shannon hizo su tesis de master en MIT que implementó álgebra booleana usando relés electrónicos e interruptores por primera vez en la historia. Titulada "Un Análisis Simbólico de Circuitos de Relés e Interruptores" (A Symbolic Analysis of Relay and Switching Circuits), la tesis de Shannon, esencialmente, fundó el diseño de circuitos digitales prácticos. La máquina subsecuente de Zuse, la Z3, fue terminada en 1941. Estaba basada en relés de teléfono y trabajó satisfactoriamente. Así, la Z3 fue la primera computadora funcional controlada mediante programas. En muchas de sus características era bastante similar a las máquinas modernas, abriendo numerosos avances, tales como el uso de la aritmética binaria y números de coma flotante. El duro trabajo de reemplazar el sistema decimal (utilizado en el primer diseño de Charles Babbage) por el sistema binario, más simple, significó que las máquinas de Zuse fuesen más fáciles de construir y potencialmente más fiables, dadas las tecnologías disponibles en ese momento. Esto es a veces visto como la principal razón por la que Zuse tuvo éxito donde Babbage falló; sin embargo, aunque la mayoría de las máquinas de propósito general de la actualidad continúan ejecutando instrucciones binarias, la aritmética decimal es aún esencial para aplicaciones comerciales, financieras, científicas y de entretenimiento, y el hardware de coma flotante decimal está siendo agregado en los dispositivos actuales (el sistema binario continua siendo usado para direccionamiento en casi todas las máquinas) como un apoyo al hardware binario. Se hicieron programas para las Z3 en cintas perforadas. Los saltos condicionales eran extraños, pero desde los 1990s los puristas teóricos decían que la Z3 era aún una computadora universal (ignorando sus limitaciones de tamaño de almacenamiento físicas). En dos patentes de 1937, Konrad Zuse también anticipó que las instrucciones de máquina podían ser almacenadas en el mismo tipo de almacenamiento utilizado por los datos - la clave de la visión que fue conocida como la arquitectura de von Neumann y fue la primera implementada en el diseño Británico EDSAC (1949) más tarde. Zuse también diseño el primer lenguaje de programación de alto nivel "Plankalkül" en 1945, aunque nunca se publicó formalmente hasta 1971, y fue implementado la primera vez en el 2000 por la Universidad de Berlín, cinco años después de la muerte de Zuse. Zuse sufrió retrocesos dramáticos y perdió muchos años durante la Segunda Guerra Mundial cuando los bombarderos británicos o estadounidenses destruyeron sus primeras máquinas. Al parecer su trabajo permaneció largamente desconocido para los ingenieros del Reino Unido y de los Estados Unidos. Aún así, IBM era consciente de esto y financió su compañía a inicios de la post-guerra en 1946, para obtener derechos sobre las patentes de Zuse. En 1940, fue completada la Calculadora de Número Complejo, una calculadora para aritmética compleja basada en relés. Fue la primera máquina que siempre se usó remotamente encima de una línea telefónica. En 1938, John Vincent Atanasoff y Clifford E. Berry de la Universidad del Estado de Iowa desarrollaron la Atanasoff Berry Computer (ABC) una computadora de propósito especial para resolver sistemas de ecuaciones lineales, y que emplearon condensadores montados mecánicamente en un tambor rotatorio para memoria. La máquina ABC no era programable, aunque se considera una computadora en el sentido moderno en varios otros aspectos. Durante la Segunda Guerra Mundial, los británicos hicieron esfuerzos significativos en Bletchley Park para descifrar las comunicaciones militares alemanas. El sistema cypher alemán (Enigma), fue atacado con la ayuda con las finalidad de construir bombas (diseñadas después de las bombas electromecánicas programables) que ayudaron a encontrar posibles llaves Enigmas después de otras técnicas tenían estrechadas bajo las posibilidades. Los alemanes también desarrollaron una serie de sistemas cypher (llamadas Fish cyphers por los británicos y Lorenz cypers por los alemanes) que eran bastante diferentes del Enigma. Como parte de un ataque contra estos, el profesor Max Newman y sus colegas (incluyendo Alan Turing) construyeron el Colossus. El Mk I Colossus fue construido en un plazo muy breve por Tommy Flowers en la Post Office Research Station en Dollis Hill en Londres y enviada a Bletchley Park. El Colossus fue el primer dispositivo de cómputo totalmente electrónico. El Colossus usó solo tubos de vacío y no tenía relés. Tenía entrada para cinta de papel [paper-tape] y fue capaz de hacer bifurcaciones condicionales. Se construyeron nueve Mk II Colossi (la Mk I se convirtió a una Mk II haciendo diez máquinas en total). Los detalles de su existencia, diseño, y uso se mantuvieron en secreto hasta los años 1970. Se dice que Winston Churchill había emitido personalmente una orden para su destrucción en pedazos no más grandes que la mano de un hombre. Debido a este secreto el Colossi no se ha incluido en muchas historias de la computación. Una copia reconstruida de una de las máquinas Colossus esta ahora expuesta en Bletchley Park. El trabajo de preguerra de Turing ejerció una gran influencia en la ciencia de la computación teórica, y después de la guerra, diseñó, construyó y programó algunas de las primeras computadoras en el Laboratorio Nacional de Física y en la Universidad de Mánchester. Su trabajo de 1936 incluyó una reformulación de los resultados de Kurt Gödel en 1931 así como una descripción de la que ahora es conocida como la máquina de Turing, un dispositivo puramente teórico para formalizar la noción de la ejecución de algoritmos, reemplaza al lenguaje universal, más embarazoso, de Gödel basado en aritmética. Las computadoras modernas son Turing-integrada (capacidad de ejecución de algoritmo equivalente a una máquina Turing universal), salvo su memoria finita. Este limitado tipo de Turing-integrados es a veces visto como una capacidad umbral separando las computadoras de propósito general de sus predecesores de propósito especial. George Stibitz y sus colegas en Bell Labs de la ciudad de Nueva York produjeron algunas computadoras basadas en relés a finales de los años 1930 y a principios de los años 1940, pero se preocuparon más de los problemas de control del sistema de teléfono, no en computación. Sus esfuerzos, sin embargo, fueron un claro antecedente para otra máquina electromecánica americana. La Harvard Mark I (oficialmente llamada Automatic Sequence Controlled Calculator) fue una computadora electro-mecánica de propósito general construida con financiación de IBM y con asistencia de algún personal de IBM bajo la dirección del matemático Howard Aiken de Harvard. Su diseño fue influenciado por la Máquina Analítica. Fue una máquina decimal que utilizó ruedas de almacenamiento e interruptores rotatorios además de los relés electromagnéticos. Se programaba mediante cinta de papel perforado, y contenía varias calculadoras trabajando en paralelo. Más adelante los modelos contendrían varios lectores de cintas de papel y la máquina podía cambiar entre lectores basados en una condición. No obstante, esto no hace mucho la máquina Turing-integrada. El desarrollo empezó en 1939 en los laboratorio de Endicott de IBM; la Mark I se llevó a la Universidad de Harvard para comenzar a funcionar en mayo de 1944. ENIACLa construcción estadounidense ENIAC (Electronic Numerical Integrator and Computer), a menudo llamada la primera computadora electrónica de propósito general, públicamente validó el uso de elementos electrónicos para computación a larga escala. Esto fue crucial para el desarrollo de la computación moderna, inicialmente debido a la ventaja de su gran velocidad, pero últimamente debido al potencial para la miniaturización.Construida bajo la dirección de John Mauchly y J. Presper Eckert, era mil veces más rápida que sus contemporáneas. El desarrollo y construcción de la ENIAC comenzó en 1941 siendo completamente operativa hacia finales de 1945. Cuando su diseño fue propuesto, muchos investigadores creyeron que las miles de válvulas delicadas (tubos de vacío) se quemarían a menudo, lo que implicaría que la ENIAC estuviese muy frecuentemente en reparación. Era, sin embargo, capaz de hacer más de 100.000 cálculos simples por segundo y eso durante unas horas que era el tiempo entre fallos de las válvulas. Para programar la ENIAC, sin embargo, se debía realambrar por lo que algunos dicen que eso ni siquiera se puede calificar como programación, pues cualquier tipo de reconstrucción de una computadora se debería considerar como programación. Varios años después, sin embargo, fue posible ejecutar programas almacenados en la memoria de la tabla de función. A todas las máquinas de esta época les faltó lo que se conocería como la arquitectura de Eckert-Mauchly: sus programas no se guardaron en el mismo "espacio" de memoria como los datos y así los programas no pudieron ser manipulados como datos. La primera máquinas Eckert-Mauchly fue la Manchester Baby o Small-Scale Experimental Machine, construida en la Universidad de Manchester en 1948; esta fue seguida en 1949 por la computadora Manchester Mark I que funcionó como un sistema completo utilizando el tubo de William para memoria, y también introdujo registros de índices. El otro contendiente para el título "primera computadora digital de programa almacenado" fue EDSAC, diseñada y construida en la Universidad de Cambridge. Estuvo operativa menos de un año después de la Manchester "Baby" y era capaz de resolver problemas reales. La EDSAC fue realmente inspirada por los planes para la EDVAC, el sucesor de la ENIAC; estos planes ya estaban en lugar por el tiempo la ENIAC fue exitosamente operacional. A diferencia la ENIAC, que utilizo procesamiento paralelo, la EDVAC usó una sola unidad de procesamiento. Este diseño era más simple y fue el primero en ser implementado en cada onda teniendo éxito de miniaturización, e incrementó la fiabilidad. Algunos ven la Manchester Mark I/EDSAC/EDVAC como las "Evas" de que casi todas las computadoras actuales que derivan de su arquitectura. La primera computadora programable en la Europa continental fue creada por un equipo de científicos bajo la dirección de Segrey Alekseevich Lebedev del Institute of Electrotechnology en Kiev, Unión Soviética (ahora Ucrania). La computadora MESM (Small Electronic Calculating Machine (МЭСМ)) fue operacional en 1950. Tenía aproximadamente 6.000 tubos de vacío y consumía 25 kW. Podía realizar aproximadamente 3.000 operaciones por segundo. La máquina de la Universidad de Manchester se convirtió en el prototipo para la Ferranti Mark I. La primera máquina Ferranti Mark I fue entregada a la Universidad en febrero de 1951 y por lo menos otras nueve se vendieron entre 1951 y 1957. UNIVAC IEn junio de 1951, la UNIVAC I [Universal Automatic Computer] se entregó a la Oficina del Censo estadounidense. Aunque fabricada por la Remington Rand, la máquina era erróneamente llamada la "IBM UNIVAC". La Remington Rand eventualmente vendió 46 máquinas a más de $1 millón cada una. La UNIVAC fue la primera computadora "producida en masa"; todas las predecesoras habían sido "una fuera de" las unidades. Usaba 5.200 tubos de vacío y consumía 125 kW. Utilizó una línea de retraso de mercurio capaz de almacenar 1.000 palabras de 11 dígitos decimales más la señal (72-bit de palabras) para memoria. En contraste con las primeras máquinas no usó un sistema de tarjetas perforadas, sino una entrada de cinta de metal.En 1949, la Remington Rand había demostrado el primer prototipo de la 409, una calculadora de tarjeta perforada de tarjeta enchufada programada. Esta fue la primera instalada, en la Revenue Service facility en Baltimore, en 1952. La 409 evolucionó para volverse la computadora Univac 60 y 120 en 1953. LEOEn noviembre de 1952, la compañía J. Lyons and Co. (relacionada con la industria de los alimentos) desarrolló la primera computadora de Inglaterra la LEO (Lyons Electronic Office), esta también fue la primera computadora en resolver problemas de negocios. La computadora contenía una aplicación que resolvía el problema de la producción y entrega de pasteles a las tiendas de la misma compañía.1La segunda Generacion Segunda generación de computadorasLa segunda generación de las computadoras reemplazó a las válvulas de vacío por los transistores.Por eso, las computadoras de la segunda generación son más pequeñas y consumen menos electricidad que las anteriores, la forma de comunicación con estas nuevas computadoras es mediante lenguajes más avanzados que el lenguaje de máquina, y que reciben el nombre de "lenguajes de alto nivel" o lenguajes de programación. Las características más relevantes de las computadoras de la segunda generación son:

Tercera generación de computadorasA mediados de los años 60 se produjo la invención del circuito integrado o microchip, por parte de Jack St. Claire Kilby y Robert Noyce. Después llevó a Ted Hoff a la invención del microprocesador, en Intel. A finales de 1960, investigadores como George Gamow notó que las secuencias de nucleótidos en el ADN formaban un código, otra forma de codificar o programar. A partir de esta fecha, empezaron a empaquetarse varios transistores diminutos y otros componentes electrónicos en un solo chip o encapsulado, que contenía en su interior un circuito completo: un amplificador, un oscilador, o una puerta lógica. Naturalmente, con estos chips (circuitos integrados) era mucho más fácil montar aparatos complicados: receptores de radio o televisión y computadoras. En 1965, IBM anunció el primer grupo de máquinas construidas con circuitos integrados, que recibió el nombre de serie Edgar. Estas computadoras de tercera generación sustituyeron totalmente a los de segunda, introduciendo una forma de programar que aún se mantiene en las grandes computadoras actuales. Esto es lo que ocurrió en (1964-1971) que comprende de la Tercera generación de computadoras:

La cuarta Generacion Cuarta generación de computadorasLa denominada Cuarta Generación (1971 a 1981) es el producto de la microminiaturización de los circuitos electrónicos. El tamaño reducido del microprocesador de chips hizo posible la creación de las computadoras personales (PC). Hoy en día las tecnologías LSI (Integración a gran escala) y VLSI (integración a muy gran escala) permiten que cientos de miles de componentes electrónicos se almacenen en un chip. Usando VLSI, un fabricante puede hacer que una computadora pequeña rivalice con una computadora de la primera generación que ocupaba un cuarto completo. Hicieron su gran debut las microcomputadoras.HistoriaLas microcomputadoras o Computadoras Personales (PC´s) tuvieron su origen con la creación de los microprocesadores. Un microprocesador es "una computadora en un chip", o sea un circuito integrado independiente. Las PC´s son computadoras para uso personal y relativamente son baratas y actualmente se encuentran en las oficinas, escuelas y hogares.El término PC se deriva para el año de 1981, IBM, sacó a la venta su modelo "IBM PC",cual se convirtió en un tipo de computadora ideal para uso "personal", de ahí que el término "PC" se estandarizó y los clones que sacaron posteriormente otras empresas fueron llamados "PC y compatibles", usando procesadores del mismo tipo que las IBM , pero a un costo menor y pudiendo ejecutar el mismo tipo de programas. Existen otros tipos de microcomputadoras , como la Macintosh, que no son compatibles con la IBM, pero que en muchos de los casos se les llaman también "PC´s", por ser de uso personal. El primer microprocesador fue el Intel 4004, producido en 1971. Se desarrolló originalmente para una calculadora, y resultaba revolucionario para su época. Contenía 2.300 transistores en un microprocesador de 4 bits que sólo podía realizar 60.000 operaciones por segundo. MicroprocesadoresEl primer microprocesador de 8 bits fue el Intel 8008, desarrollado en 1972 para su empleo en terminales informáticos. El Intel 8008 contenía 3.300 transistores. El primer microprocesador realmente diseñado para uso general, desarrollado en 1974, fue el Intel 8080 de 8 bits, que contenía 4.500 transistores y podía ejecutar 200.000 instrucciones por segundo. Los microprocesadores modernos tienen una capacidad y velocidad mucho mayores.Entre ellos figuran el Intel Pentium Pro, con 5,5 millones de transistores; el UltraSparc-II, de Sun Microsystems, que contiene 5,4 millones de transistores; el PowerPC 620, desarrollado conjuntamente por Apple, IBM y Motorola, con 7 millones de transistores, y el Alpha 21164A, de Digital Equipment Corporation, con 9,3 millones de transistores. El Microprocesador, es un circuito electrónico que actúa como unidad central de proceso de un ordenador, proporcionando el control de las operaciones de cálculo. Los microprocesadores también se utilizan en otros sistemas informáticos avanzados, como impresoras, automóviles o aviones. En 1995 se produjeron unos 4.000 millones de microprocesadores en todo el mundo. El microprocesador es un tipo de circuito sumamente integrado. Los circuitos integrados, también conocidos como microchips o chips, son circuitos electrónicos complejos formados por componentes extremadamente pequeños formados en una única pieza plana de poco espesor de un material conocido como semiconductor. Los microprocesadores modernos incorporan hasta 10 millones de transistores (que actúan como amplificadores electrónicos, osciladores o, más a menudo, como conmutadores), además de otros componentes como resistencias, diodos, condensadores y conexiones, todo ello en una superficie comparable a la de un sello postal. Un microprocesador consta de varias secciones diferentes. La unidad aritmético-lógica (ALU, siglas en inglés) efectúa cálculos con números y toma decisiones lógicas; los registros son zonas de memoria especiales para almacenar información temporalmente; la unidad de control descodifica los programas; los buses transportan información digital a través del chip y de la computadora; la memoria local se emplea para los cómputos realizados en el mismo chip. Los microprocesadores más complejos contienen a menudo otras secciones; por ejemplo, secciones de memoria especializada denominadas memoria cache, modernos funcionan con una anchura de bus de 64 bits: esto significa que pueden transmitirse simultáneamente 64 bits de datos. Un cristal oscilante situado en el ordenador proporciona una señal de sincronización, o señal de reloj, para coordinar todas las actividades del microprocesador. La quinta Generacion Quinta generación de computadorasLa quinta generación de computadoras, también conocida por sus siglas en inglés, FGCS (de Fifth Generation Computer Systems) fue un ambicioso proyecto propuesto por Japón a finales de la década de 1970. Su objetivo era el desarrollo de una nueva clase de computadoras que utilizarían técnicas y tecnologías de inteligencia artificial tanto en el plano del hardware como del software,1 usando el lenguaje PROLOG2 3 4 al nivel del lenguaje de máquina y serían capaces de resolver problemas complejos, como la traducción automática de una lengua natural a otra (del japonés al inglés, por ejemplo).Como unidad de medida del rendimiento y prestaciones de estas computadoras se empleaba la cantidad de LIPS (Logical Inferences Per Second) capaz de realizar durante la ejecución de las distintas tareas programadas. Para su desarrollo se emplearon diferentes tipos de arquitecturas VLSI (Very Large Scale Integration). El proyecto duró once años, pero no obtuvo los resultados esperados: las computadoras actuales siguieron así, ya que hay muchos casos en los que, o bien es imposible llevar a cabo una paralelización del mismo, o una vez llevado a cabo ésta, no se aprecia mejora alguna, o en el peor de los casos, se produce una pérdida de rendimiento. Hay que tener claro que para realizar un programa paralelo debemos, para empezar, identificar dentro del mismo partes que puedan ser ejecutadas por separado en distintos procesadores. Además, es importante señalar que un programa que se ejecuta de manera secuencial, debe recibir numerosas modificaciones para que pueda ser ejecutado de manera paralela, es decir, primero sería interesante estudiar si realmente el trabajo que esto conlleva se ve compensado con la mejora del rendimiento de la tarea después de paralelizarla. Historia y desarrollo del proyectoAntecedentes y diseñoA través de las múltiples generaciones desde los años 50, Japón había sido el seguidor en términos del adelanto y construcción de las computadoras basadas en los modelos desarrollados en los Estados Unidos y el Reino Unido. Japón, a través de su Ministerio de Economía, Comercio e Industria (MITI) decidió romper con esta naturaleza de seguir a los líderes y a mediados de la década de los 70 comenzó a abrirse camino hacia un futuro en la industria de la informática. El Centro de Desarrollo y Proceso de la Información de Japón (JIPDEC) fue el encargado llevar a cabo un plan para desarrollar el proyecto. En 1979 ofrecieron un contrato de tres años para realizar estudios más profundos con la participación conjunta de empresas de la industria dedicadas a la tecnología e instituciones académicas, a instancias de Hazime Hiroshi. Fue durante este período cuando el término "computadora de quinta generación" comenzó a ser utilizado.InicioEn 1981 a iniciativa del MITI se celebró una Conferencia Internacional, durante la cual Kazuhiro Fuchi anunció el programa de investigación y el 14 de abril de 1982 el gobierno decidió lanzar oficialmente el proyecto, creando el Institute for New Generation Computer Technology (Instituto para la Nueva Generación de Tecnologías de Computación o ICOT por sus siglas en inglés), bajo la dirección de Fuchi,5 a quien sucedería en el puesto como director del instituto Tohru Moto-Oka, y con la participación de investigadores de diversas empresas japonesas dedicadas al desarrollo de hardware y software, entre ellas Fujitsu, NEC, Matsushita, Oki, Hitachi, Toshiba y Sharp.6Los campos principales para la investigación de este proyecto inicialmente eran:

Impacto institucional internacionalDebido a la conmoción suscitada que causó que los japoneses fueran exitosos en el área de los artículos electrónicos durante la década de los 70, y que prácticamente hicieran lo mismo en el área de la automoción durante los 80, el proyecto de la quinta generación tuvo mucha reputación entre los otros países.7Tal fue su impacto que se crearon proyectos paralelos. En Estados Unidos, la Microelectronics and Computer Technology Corporation8 y la Strategic Computing Initiative; por parte europea, en Reino Unido fue ALVEY,8 y en el resto de Europa su reacción fue conocida como ESPRIT (European Strategic Programme for Research in Information Technology, en español Programa Estratégico Europeo en Investigación de la Tecnología de la Información).9 Popularidad internacionalAparte de las reacciones a nivel institucional, en un plano más popular comenzó a ser conocido en Occidente gracias a la aparición de libros en los que se hablaba del proyecto de manera más o menos directa o era citado10 pero principalmente por artículos aparecidos en revistas dedicadas a los aficionados a la informática; así por ejemplo, en el número de agosto de 1984 de la estadounidense Creative Computing se publicó un artículo que trataba ampliamente el tema, "The fifth generation: Japan's computer challenge to the world"11 (traducido, La Quinta Generación: El desafío informático japonés al mundo). En el ámbito de habla hispana se puede citar por ejemplo a la revista MicroHobby, que en julio de 1985 publicó12 una entrevista a Juan Pazos Sierra, Doctorado en Informática y vinculado en aquella época a la Facultad de Informática de la Universidad de Madrid, en la que describía someramente el proyecto como:...un proyecto japonés que tiene unas características curiosas y especiales; en primer lugar, la pretensión es construir un computador basado en tecnología VLSI, con una arquitectura no Von Neumann y que llevaría como núcleo de software la programación lógica, el lenguaje PROLOG, para construir finalmente sobre todo esto Sistemas Expertos.Y sobre sus potenciales resultados, expresaba una opinión relativamente optimista, en la línea de lo augurado por los propios promotores del proyecto. Así, ante la pregunta de si se había obtenido algún resultado en el mismo, respondía: De momento, nada. Se va a desarrollar muchísimo lo que ya existe, aparecerán nuevas tecnologías, nuevos Sistemas Expertos y la investigación se verá enormemente potenciada por la tremenda inyección de dinero que el proyecto quinta generación ha supuesto para la Inteligencia Artificial.Por su parte, Román Gubern, en su ensayo El simio informatizado de 1987, consideraba que: ...el ordenador de quinta generación es un verdadero intento de duplicación tecnológica del intelecto del Homo sapiens.13 Principales eventos y finalización del proyecto

Once años después del inicio del proyecto, la gran suma de dinero, infraestructura y recursos invertida en el mismo no se correspondía con los resultados esperados y se dio por concluido sin haber cumplido sus objetivos. William Zachman criticó el proyecto un año antes de su término, argumentando: Perjudica el desarrollo de aplicaciones de IA; con la IA, no importa el sistema, mientras no haya mecanismos de inferencia potentes. Ya hay un montón de aplicaciones de tipo IA, y estoy esperando la llegada del motor de inferencia potente, por eso las computadora de quinta generación son un error.17El hardware propuesto y sus desarrollos de software no tenían cabida en el mercado informático, que había evolucionado desde el momento en el que se lanzara el proyecto, y en el que sistemas de propósito general ahora podían hacerse cargo de la mayoría de las tareas propuestas como objetivos iniciales de las máquinas de quinta generación, de manera semejante a como había pasado en el caso del mercado potencial de las máquinas Lisp, en el que sistemas para la creación de Sistemas Expertos basados en reglas como CLIPS, implementados sobre computadoras comunes, habían convertido a estas costosas máquinas en innecesarias y obsoletas.18 Por otra parte, dentro de las disputas entre las diferentes ramas de la Inteligencia Artificial, el proyecto japonés partía del paradigma basado en la programación lógica y la programación declarativa, dominante tras la publicación en 1969 por Marvin Minsky y Seymour Papert del libro Perceptrons, que pasaría progresivamente a un segundo plano en favor de la programación de Redes Neuronales Artificiales (RNA) tras la publicación en 1986 por parte de McClelland y Rumelhart del libro Parallel Distributed Processing, lo que junto a sus escasos resultados contribuyó a que el proyecto de la quinta generación cayera en el olvido a su término en 1993. El Institute for New Generation Computer Technology (ICOT) fue renombrado en el año 1995 a Research Institute for Advanced Information Technology (AITEC), centro que fue clausurado en 2003, pasando todos sus recursos al Advanced IT Research Group (AITRG), dependiente del Departamento de Investigación del JIPDEC. HardwarePrimera etapaMáquinas secuenciales PSI (Personal Sequential Inference machine) y CHI (Co-operative High-performance Inference machine):

Segunda etapaMáquinas secuenciales:

Tercera etapaMáquinas en paralelo:

La sexta Generacion Sistemas operativos

Los sistemas operativos han ido evolucionando como todo en la vida,

dedico esta página porque algunos usuarios de mi blog me han comentado

que estaban pegadísimos y que no tenían ni idea de lo que era un sistema

operativo, no parar de oír hablar, de windows no se que o de windows no

se cuanto, de android punto no se cuanto o de blackberry,

así que en esta página me limito a explicar que es un sistema operativo

y los tipos de sistemas habidos hasta el momento, sino no sabes sobre

el tema y te interesa estar a la ultima o saber algo del pasado de los

sistemas operativos esta es tu página, espero que la disfruten.

Curioso vídeo de la evolución de los sistemas operativos. Sistema operativoUn sistema operativo (SO, frecuentemente OS, del inglés Operating System) es un programa o conjunto de programas que en un sistema informático gestiona los recursos de hardware y provee servicios a los programas de aplicación, ejecutándose en modo privilegiado respecto de los restantes.2Nótese que es un error común muy extendido denominar al conjunto completo de herramientas sistema operativo, es decir, la inclusión en el mismo término de programas como el explorador de ficheros, el navegador web y todo tipo de herramientas que permiten la interacción con el sistema operativo, también llamado núcleo o kernel. Esta identidad entre kernel y sistema operativo es solo cierta si el núcleo es monolítico. Otro ejemplo para comprender esta diferencia se encuentra en la plataforma Amiga, donde el entorno gráfico de usuario se distribuía por separado, de modo que, también podía reemplazarse por otro, como era el caso de directory Opus o incluso manejarlo arrancando con una línea de comandos y el sistema gráfico. De este modo, al arrancar un Amiga, comenzaba a funcionar con el propio sistema operativo que llevaba incluido en una ROM, por lo que era cuestión del usuario decidir si necesitaba un entorno gráfico para manejar el sistema operativo o simplemente otra aplicación. Uno de los más prominentes ejemplos de esta diferencia, es el núcleo Linux, usado en las llamadas distribuciones Linux, ya que al estar también basadas en Unix, proporcionan un sistema de funcionamiento similar. Este error de precisión, se debe a la modernización de la informática llevada a cabo a finales de los 80, cuando la filosofía de estructura básica de funcionamiento de los grandes computadores3 se rediseñó a fin de llevarla a los hogares y facilitar su uso, cambiando el concepto de computador multiusuario, (muchos usuarios al mismo tiempo) por un sistema monousuario (únicamente un usuario al mismo tiempo) más sencillo de gestionar.4 (Véase AmigaOS, beOS o MacOS como los pioneros5 de dicha modernización, cuando los Amiga fueron bautizados con el sobrenombre de Video Toasters6 por su capacidad para la Edición de vídeo en entorno multitarea round robin, con gestión de miles de colores e interfaces intuitivos para diseño en 3D. Uno de los propósitos del sistema operativo que gestiona el núcleo intermediario consiste en gestionar los recursos de localización y protección de acceso del hardware, hecho que alivia a los programadores de aplicaciones de tener que tratar con estos detalles. La mayoría de aparatos electrónicos que utilizan microprocesadores para funcionar, llevan incorporado un sistema operativo (teléfonos móviles, reproductores de DVD, computadoras, radios, enrutadores, etc.). En cuyo caso, son manejados mediante una Interfaz Gráfica de Usuario, un gestor de ventanas o un entorno de escritorio, si es un celular, mediante una consola o control remoto si es un DVD y, mediante una línea de comandos o navegador web si es un enrutador. Perspectiva históricaLos primeros sistemas (1945-1955) eran grandes máquinas operadas desde la consola maestra por los programadores. Durante la década siguiente (1955-1965) se llevaron a cabo avances en el hardware: lectoras de tarjetas, impresoras, cintas magnéticas, etc. Esto a su vez provocó un avance en el software: compiladores, ensambladores, cargadores, manejadores de dispositivos, etc.A finales de los años 1980, una computadora Commodore Amiga equipada con una aceleradora Video Toaster era capaz de producir efectos comparados a sistemas dedicados que costaban el triple. Un Video Toaster junto a Lightwave ayudó a producir muchos programas de televisión y películas, entre las que se incluyen Babylon 5, Seaquest DSV y Terminator II.7 Problemas de explotación y soluciones inicialesEl problema principal de los primeros sistemas era la baja utilización de los mismos, la primera solución fue poner un operador profesional que lo manejase, con lo que se eliminaron las hojas de reserva, se ahorró tiempo y se aumentó la velocidad.Para ello, los trabajos se agrupaban de forma manual en lotes mediante lo que se conoce como procesamiento por lotes (batch) sin automatizar. Monitores residentesSegún fue avanzando la complejidad de los programas, fue necesario implementar soluciones que automatizaran la organización de tareas sin necesidad de un operador. Debido a ello se crearon los monitores residentes: programas que residían en memoria y que gestionaban la ejecución de una cola de trabajos.Un monitor residente estaba compuesto por un cargador, un Intérprete de comandos y un Controlador (drivers) para el manejo de entrada/salida. Sistemas con almacenamiento temporal de E/SLos avances en el hardware crearon el soporte de interrupciones y posteriormente se llevó a cabo un intento de solución más avanzado: solapar la E/S de un trabajo con sus propios cálculos, por lo que se creó el sistema de búfers con el siguiente funcionamiento:

SpoolersHace aparición el disco magnético con lo que surgen nuevas soluciones a los problemas de rendimiento. Se eliminan las cintas magnéticas para el volcado previo de los datos de dispositivos lentos y se sustituyen por discos (un disco puede simular varias cintas). Debido al solapamiento del cálculo de un trabajo con la E/S de otro trabajo se crean tablas en el disco para diferentes tareas, lo que se conoce como Spool (Simultaneous Peripherial Operation On-Line).Sistemas operativos multiprogramadosSurge un nuevo avance en el hardware: el hardware con protección de memoria. Lo que ofrece nuevas soluciones a los problemas de rendimiento:

Llamadas al sistema operativoDefinición breve: llamadas que ejecutan los programas de aplicación para pedir algún servicio al SO.Cada SO implementa un conjunto propio de llamadas al sistema. Ese conjunto de llamadas es la interfaz del SO frente a las aplicaciones. Constituyen el lenguaje que deben usar las aplicaciones para comunicarse con el SO. Por ello si cambiamos de SO, y abrimos un programa diseñado para trabajar sobre el anterior, en general el programa no funcionará, a no ser que el nuevo SO tenga la misma interfaz. Para ello:

Modos de ejecución en un CPULas aplicaciones no deben poder usar todas las instrucciones de la CPU. No obstante el Sistema Operativo, tiene que poder utilizar todo el conjunto de instrucciones del CPU. Por ello, una CPU debe tener (al menos) dos modos de operación diferentes:

Llamadas al sistemaUna aplicación, normalmente no sabe dónde está situada la rutina de servicio de la llamada. Por lo que si ésta se codifica como una llamada de función, cualquier cambio en el S.O. haría que hubiera que reconstruir la aplicación.Pero lo más importante es que una llamada de función no cambia el modo de ejecución de la CPU. Con lo que hay que conseguir llamar a la rutina de servicio, sin tener que conocer su ubicación, y hacer que se fuerce un cambio de modo de operación de la CPU en la llamada (y la recuperación del modo anterior en el retorno). Esto se hace utilizando instrucciones máquina diseñadas específicamente para este cometido, distintas de las que se usan para las llamadas de función. Bibliotecas de interfaz de llamadas al sistemaLas llamadas al sistema no siempre tienen una expresión sencilla en los lenguajes de alto nivel, por ello se crean las bibliotecas de interfaz, que son bibliotecas de funciones que pueden usarse para efectuar llamadas al sistema. Las hay para distintos lenguajes de programación.La aplicación llama a una función de la biblioteca de interfaz (mediante una llamada normal) y esa función es la que realmente hace la llamada al sistema. Interrupciones y excepcionesEl SO ocupa una posición intermedia entre los programas de aplicación y el hardware. No se limita a utilizar el hardware a petición de las aplicaciones ya que hay situaciones en las que es el hardware el que necesita que se ejecute código del SO. En tales situaciones el hardware debe poder llamar al sistema, pudiendo deberse estas llamadas a dos condiciones:

Según los dos casos anteriores tenemos las interrupciones y la excepciones:

Tratamiento de las interrupcionesUna interrupción se trata en todo caso, después de terminar la ejecución de la instrucción en curso.El tratamiento depende de cuál sea el dispositivo de E/S que ha causado la interrupción, ante la cual debe poder identificar el dispositivo que la ha causado. La ventaja de este procedimiento es que no se tiene que perder tiempo ejecutando continuamente rutinas para consultar el estado del periférico. El inconveniente es que el dispositivo debe tener los circuitos electrónicos necesarios para acceder al sistema de interrupciones del computador. Importancia de las interrupcionesEl mecanismo de tratamiento de las interrupciones permite al SO utilizar la CPU en servicio de una aplicación, mientras otra permanece a la espera de que concluya una operación en un dispositivo de E/S.El hardware se encarga de avisar al SO cuando el dispositivo de E/S ha terminado y el SO puede intervenir entonces, si es conveniente, para hacer que el programa que estaba esperando por el dispositivo, se continúe ejecutando. En ciertos intervalos de tiempo puede convenir no aceptar señales de interrupción. Por ello las interrupciones pueden inhibirse por programa (aunque esto no deben poder hacerlo las mismas). Un ejemplo de sincronismo por interrupción es el almacenamiento de caracteres introducidos mediante el teclado. Cuando se introduce un carácter, se codifica en el registro de datos del dispositivo y además se activa un bit del registro de estado quien crea una interrupción en el hardware. El procesador deja temporalmente la tarea que estaba completando y ejecuta la rutina de atención a la interrupción correspondiente. El teclado almacena el carácter en el vector de memoria intermedia ( también llamado buffer) asociada al teclado y despierta el proceso que había en el estado de espera de la operación de entrada/salida. ExcepcionesCuando la CPU intenta ejecutar una instrucción incorrectamente construida, la unidad de control lanza una excepción para permitir al SO ejecutar el tratamiento adecuado. Al contrario que en una interrupción, la instrucción en curso es abortada. Las excepciones al igual que las interrupciones deben estar identificadas.Clases de excepcionesLas instrucciones de un programa pueden estar mal construidas por diversas razones:

Importancia de las excepcionesEl mecanismo de tratamiento de las excepciones es esencial para impedir, junto a los modos de ejecución de la CPU y los mecanismos de protección de la memoria, que las aplicaciones realicen operaciones que no les están permitidas. En cualquier caso, el tratamiento específico de una excepción lo realiza el SO.Como en el caso de las interrupciones, el hardware se limita a dejar el control al SO, y éste es el que trata la situación como convenga. Es bastante frecuente que el tratamiento de una excepción no retorne al programa que se estaba ejecutando cuando se produjo la excepción, sino que el SO aborte la ejecución de ese programa. Este factor depende de la pericia del programador para controlar la excepción adecuadamente. Visualiza todos los sistemas operativos existentes en la historia de microsoft Componentes de un sistema operativoGestión de procesosUn proceso es simplemente, un programa en ejecución que necesita recursos para realizar su tarea: tiempo de CPU, memoria, archivos y dispositivos de E/S. El SO es el responsable de:

Gestión de la memoria principalLa memoria es una gran tabla de palabras o bytes que se referencian cada una mediante una dirección única. Este almacén de datos de rápido acceso es compartido por la CPU y los dispositivos de E/S, es volátil y pierde su contenido ante fallos del sistema. El SO es el responsable de:

Gestión del almacenamiento secundarioUn sistema de almacenamiento secundario es necesario, ya que la memoria principal (almacenamiento primario) es volátil y además muy pequeña para almacenar todos los programas y datos. También es necesario mantener los datos que no convenga mantener en la memoria principal. El SO se encarga de:

El sistema de entrada y salidaConsiste en un sistema de almacenamiento temporal (caché), una interfaz de manejadores de dispositivos y otra para dispositivos concretos. El sistema operativo debe gestionar el almacenamiento temporal de E/S y servir las interrupciones de los dispositivos de E/S.Sistema de archivosLos archivos son colecciones de información relacionada, definidas por sus creadores. Éstos almacenan programas (en código fuente y objeto) y datos tales como imágenes, textos, información de bases de datos, etc. El SO es responsable de:

Desde el punto de vista del usuario estas diferencias pueden parecer insignificantes a primera vista, sin embargo, existen diferencias muy importantes. Por ejemplo, los sistemas de ficheros FAT32 y NTFS, que se utilizan fundamentalmente en sistemas operativos de Microsoft, tienen una gran diferencia para un usuario que utilice una base de datos con bastante información ya que el tamaño máximo de un fichero con un sistema de archivos FAT32 está limitado a 4 gigabytes, sin embargo, en un sistema NTFS el tamaño es considerablemente mayor. Sistemas de protecciónMecanismo que controla el acceso de los programas o los usuarios a los recursos del sistema. El SO se encarga de:

Sistema de comunicacionesPara mantener las comunicaciones con otros sistemas es necesario poder controlar el envío y recepción de información a través de las interfaces de red. También hay que crear y mantener puntos de comunicación que sirvan a las aplicaciones para enviar y recibir información, y crear y mantener conexiones virtuales entre aplicaciones que están ejecutándose localmente y otras que lo hacen remotamente.Programas de sistemaSon aplicaciones de utilidad que se suministran con el SO pero no forman parte de él. Ofrecen un entorno útil para el desarrollo y ejecución de programas, siendo algunas de las tareas que realizan:

Gestor de recursosComo gestor de recursos, el sistema operativo administra:

ClasificaciónAdministración de tareas

Administración de usuarios

Manejo de recursos

Ejemplos de sistemas operativos para PC

Ejemplos de sistemas operativos para dispositivos móviles¿Quien es Bill Gates? puedes saberlo viendo este video.

|

Páginas

- ¿Que es un videojuego?

- Real gran Diccionario del Videojuego

- ¿Que es una Computadora?

- Ordenadores de la historia

- ¿Ordenadores o consolas?

- ¿Que es una Consola?

- Consolas de Leyenda

- ¿Que es un Télefono Movil?

- ¿Que es MAME?

- Emuladores de consolas y computadoras

- Revistas, Trucos y Descargas.

- Top Decada de los 70

- top milenio pasado

- Top Milenio actual

- Bricotecnologia

- Tutorial

¿Que es una Computadora?

Suscribirse a:

Entradas (Atom)

inalización y/o interrupción.

ResponderEliminarMultitarea: Es capaz de ejecutar varios procesos al mismo tiempo. Este tipo de SO. normalmente asigna los recursos disponibles (CPU, memoria, periféricos) de forma alternada a los procesos que los solicitan, de manera que el coaching-mastery.com/consultar-curp-conseguir-informacion/